PRML勉強会

3.5.1 エビデンス関数の評価

復習

- 3.5では、対数エビデンスの最大化によって超パラメータ α,β を決める

- 3.5最後の対数エビデンスの最大化についての議論は次節

- まずは、最大化する対数エビデンス p(t|α,β) の評価とモデル選択について

パラメータのおさらい

- α は重みパラメータ w の事前分布としたガウス分布の精度(分散の逆数)

- β は観測値 t にノイズとしたガウス分布の精度

周辺尤度

- α を決定 → 重みパラメータ w の分布が分かる

- 重みパラメータ w と β が決定 → 予測結果の分布が分かる

- これらの同時分布を重みパラメータ w について周辺化したものが周辺尤度

周辺尤度の評価

p(t|α,β)

=∫p(t|w,β)p(w|α)dw

=p(t|α,β)=(β2π)N/2(α2π)M/2∫exp{−E(w)}dw

ただし、

E(w)

=βED(w)+αEww

=β2∥t−Φw∥2+α2wTw

これを w で平方完成すると

E(w)=E(mN)+12(w−mN)TA(w−mN)

ただし、

A=αI+βΦTΦ で ∇∇E(w) に対応し、

E(mN)=β2∥t−ΦmN∥2+α2mNTmN,

mN=βA−1ΦTt と定義した。mN は事後分布の平均で以前出てきた同じ記号と一致する(3.50)。

上記より、目的の関数の指数部分の積分は以下のように解ける。

∫exp{−E(w)}dw

=exp{−E(w)}∫exp−12(w−mN)TA(w−mN)dw

=exp{−E(w)}(2π)M/2|A|−1/2

求めたかった周辺尤度の対数を整理すると

lnp(t|α,β)

=M2lnα+N2lnβ−E(mN)−12ln|A|−N2ln(2π)

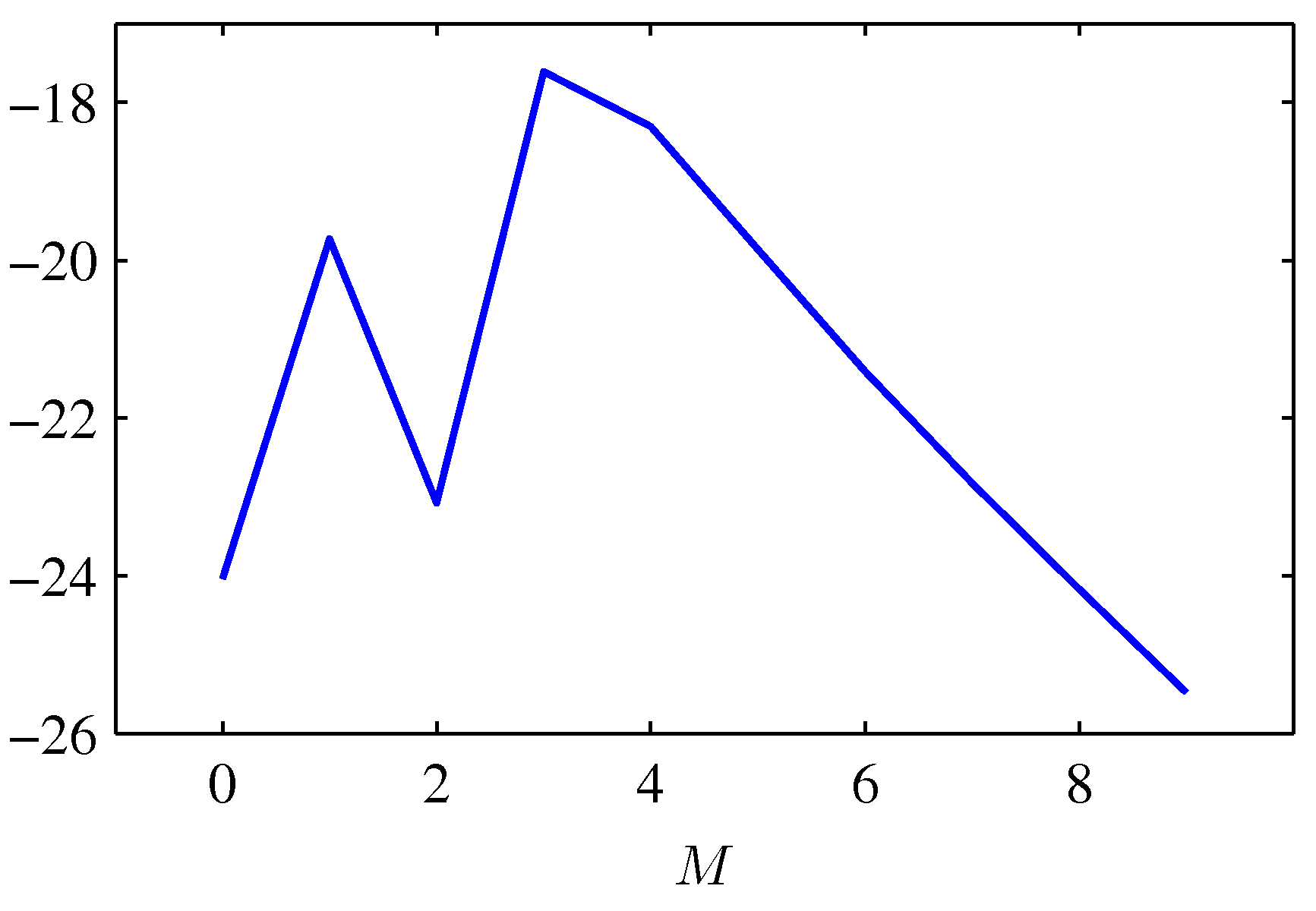

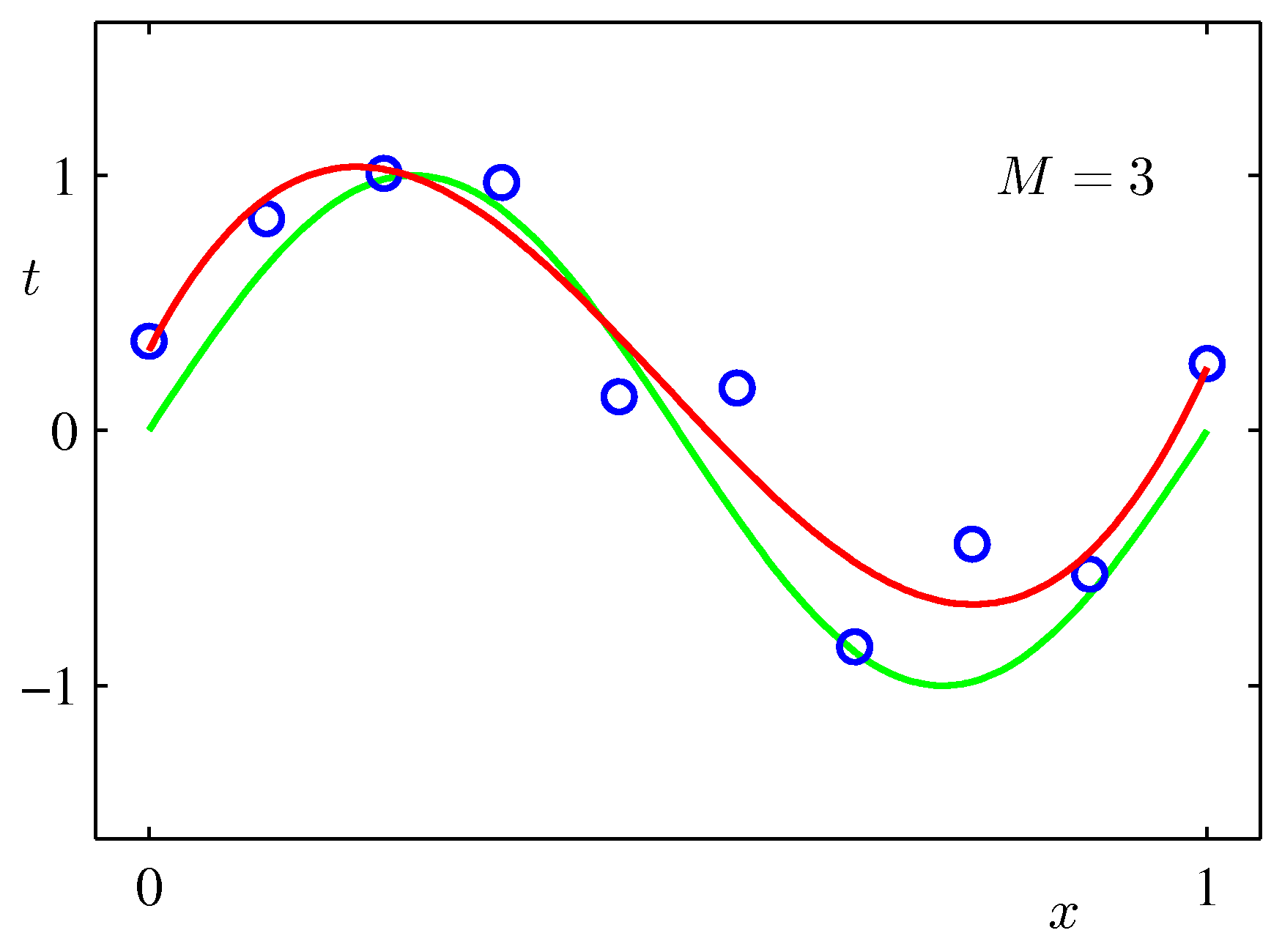

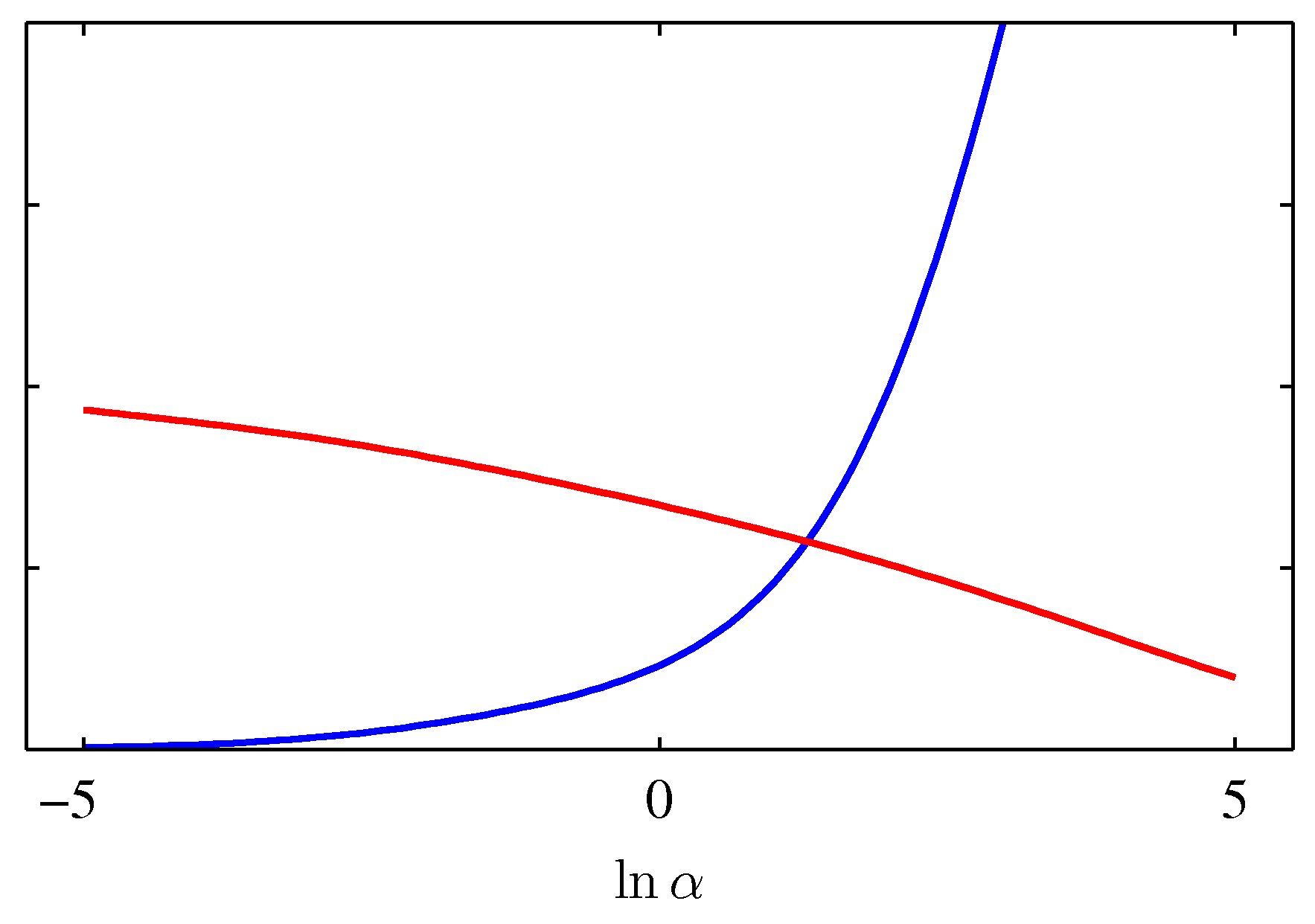

モデルエビデンス(対数表示)と多項式近似の次元数

- 得られた結果とMの関係をプロット

- 実際に「観測されたデータを説明可能なモデルのうち最も単純なものが選ばれる」ことを可視化した具体例となっている

3.5.2 エビデンス関数の最大化

α についての最大化

前節で得られた結果を超パラメータ α,β について最大化していく。

まずは α について。

A=αI+βΦTΦ の第2項について固有ベクトル方程式を考えると、

(βΦTΦ)ui=λiui

となる。

行列 A 全体で考えると、個々の固有値は α+λi となり、行列式は固有値の積(付録C.47)で計算できるので、

ddαln|A|=ddαlnΠi(α+λi)=ddα∑iln(α+λi)=∑i1α+λi

これを用いて先ほどの対数周辺尤度の α に関する微分を0とすると

M2α−12mTNmN−12∑i1α+λi=0

γ=∑iλiα+λi として整理すると

α=γmTNmN

ここで、 γ は有効パラメータ数である(次節)。

繰り返し法

α=γmTNmN の右辺は α に依存する(陰関数)

繰り返し法

- 一回の計算で答え求めることはできないので、以下の方法で数値計算を行う。

- 固有値 λ はこの依存関係に関しては定数となるので、あらかじめ求めておく。これと α,β の値を使えば γ が求まる。

- α を適当に初期化し、右辺を計算すると α の再推定値が求まる。

- 2を収束するまで繰り返す。

- 最尤推定で必要となる独立なデータ集合は必要なく、訓練データのみから計算が可能。

β についての最大化

α と同じように、陰関数の形で β を求めて、繰り返し法を行う。

行列 βΦTΦ の固有値を λi としたので、 λi は β に比例することに注意すると、

dλi/dβ=λi/β となり、

ddβln|A|=ddβ∑iln(λi+α)=1β∑iλiλi+α=γβ

β についての最大化

α と同じように対数尤度の β に関する微分を0として整理すれば

1β=1N−γN∑n=1{tn−mTNϕ(xn)}2

これは β に関する陰関数となっている。

3.5.3 有効パラメータ数

γ と α の解釈

- 前節で求めた α のベイズ推定解について考えてみる。

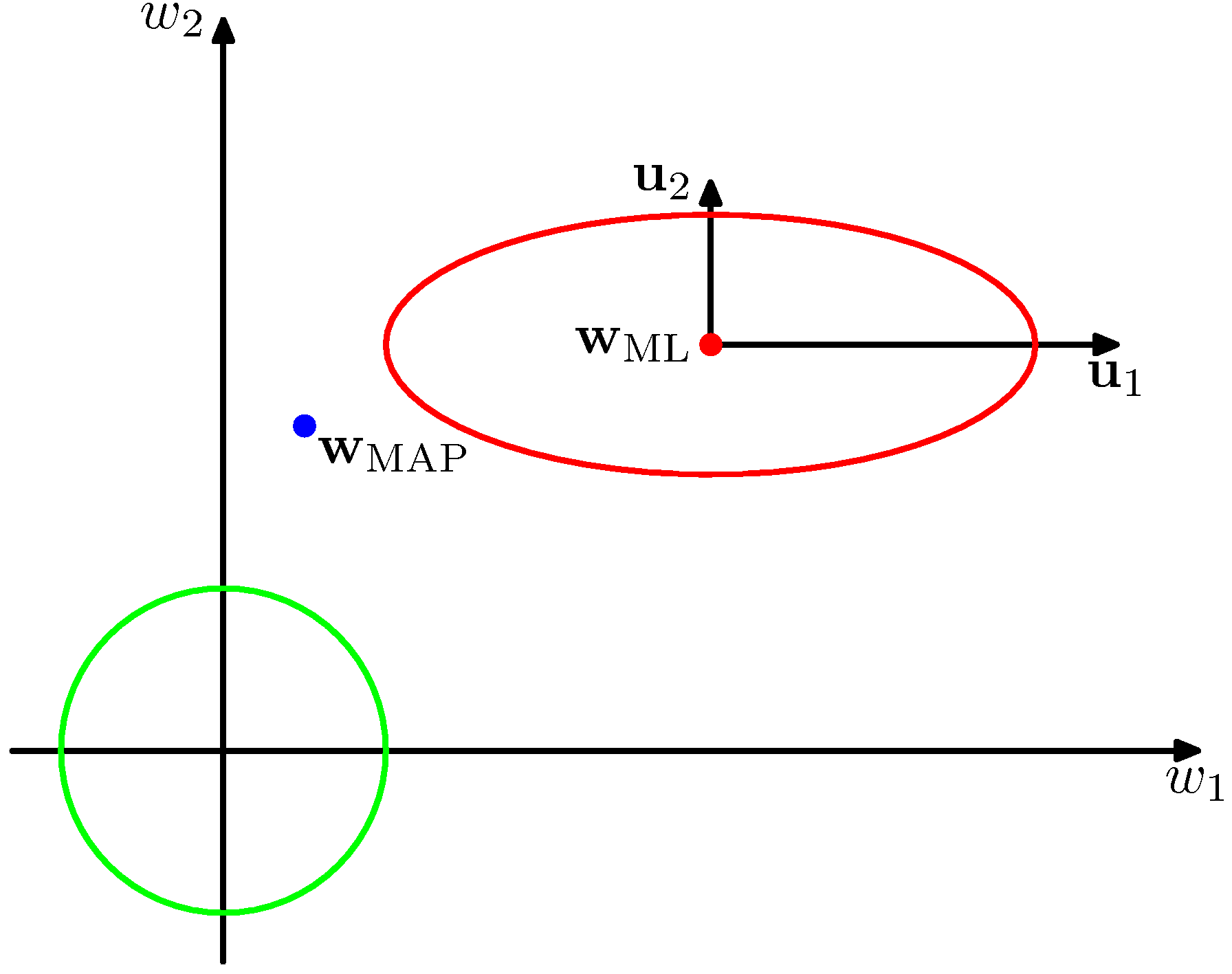

- 上図には、一様な事前確率と尤度関数の分布の等高線が、固有ベクトル ui が軸となるように回転して描かれている。

γ と α の解釈

- λi を導入した際の固有ベクトル方程式を考えると、

- (βΦTΦ)ui=λiui

- 固有値 λi は曲率で、図では λ2>λ1 となっている。

- 行列 βΦTΦ は正定値行列なので、 λi は正。

- γ=∑iλiα+λi と定義したので、0≤γ≤M となる。

γ と α の解釈

-

λi≫α となるとき、比 λi/(λi+α) は1に近い値を取り、パラメータ ωi は最尤推定値に近づく。このようなパラメータを well-determined parameter という。

-

逆に λi≪α となるとき、比 λi/(λi+α) は0に近い値を取り、パラメータ ωi は自然と事前分布に近くなる。

γ と α の解釈

- ベイズ推定では、 α の推定値によって、有効なパラメータと事前分布と変わらないパラメータを決めていると分かる。

- このとき、 γ=∑iλiα+λi は先ほどの比の合計値となっており、有効なパラメータの数を表している。

β の解釈

σ2ML=1NN∑n=1(xn−μML)2(1.56) σ2MAP=1N−1N∑n=1(xn−μML)2(10.1.3) 1β=1N−γN∑n=1{tn−mTNϕ(xn)}2(3.95)

以下の分散の最尤推定解はノイズも含めた平均の推定で減った自由度を考慮していない。

σ2ML=1NN∑n=1(xn−μML)2(1.56)

10章でベイズ的に自然に導かれる以下の分散の不偏推定量は自由度の減少を考慮している。

σ2MAP=1N−1N∑n=1(xn−μML)2(10.1.3)

前節で求めた β についての陰関数は、最尤推定がバイアスに影響を受けるのに対して、有効なパラメータが γ 個推定されたことによる自由度の減少を考慮できている。

1β=1N−γN∑n=1{tn−mTNϕ(xn)}2(3.95)

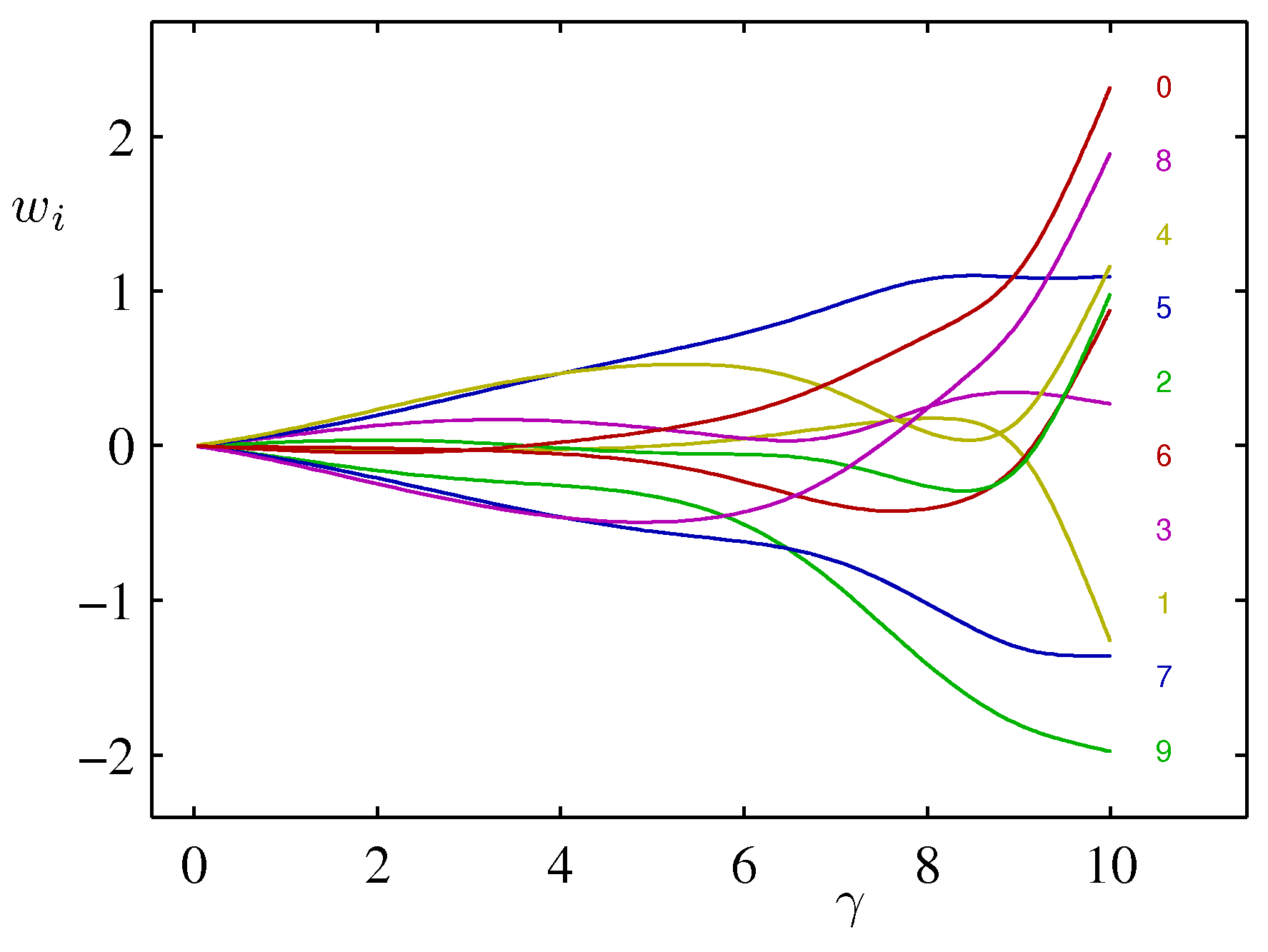

具体例

- 三角関数への多項式フィッティングについて、パラメータを10個にして再度考えてみる(バイアス項1つと基底関数9つ)。

- β をデータを生成した真の値に固定して、α のベイズ推定解を求めてみる。

γ と ωi の関係

- α は重みパラメータ w の事前分布としたガウス分布の精度(分散の逆数)

- 0≤α≤∞ で 0≤γ≤M

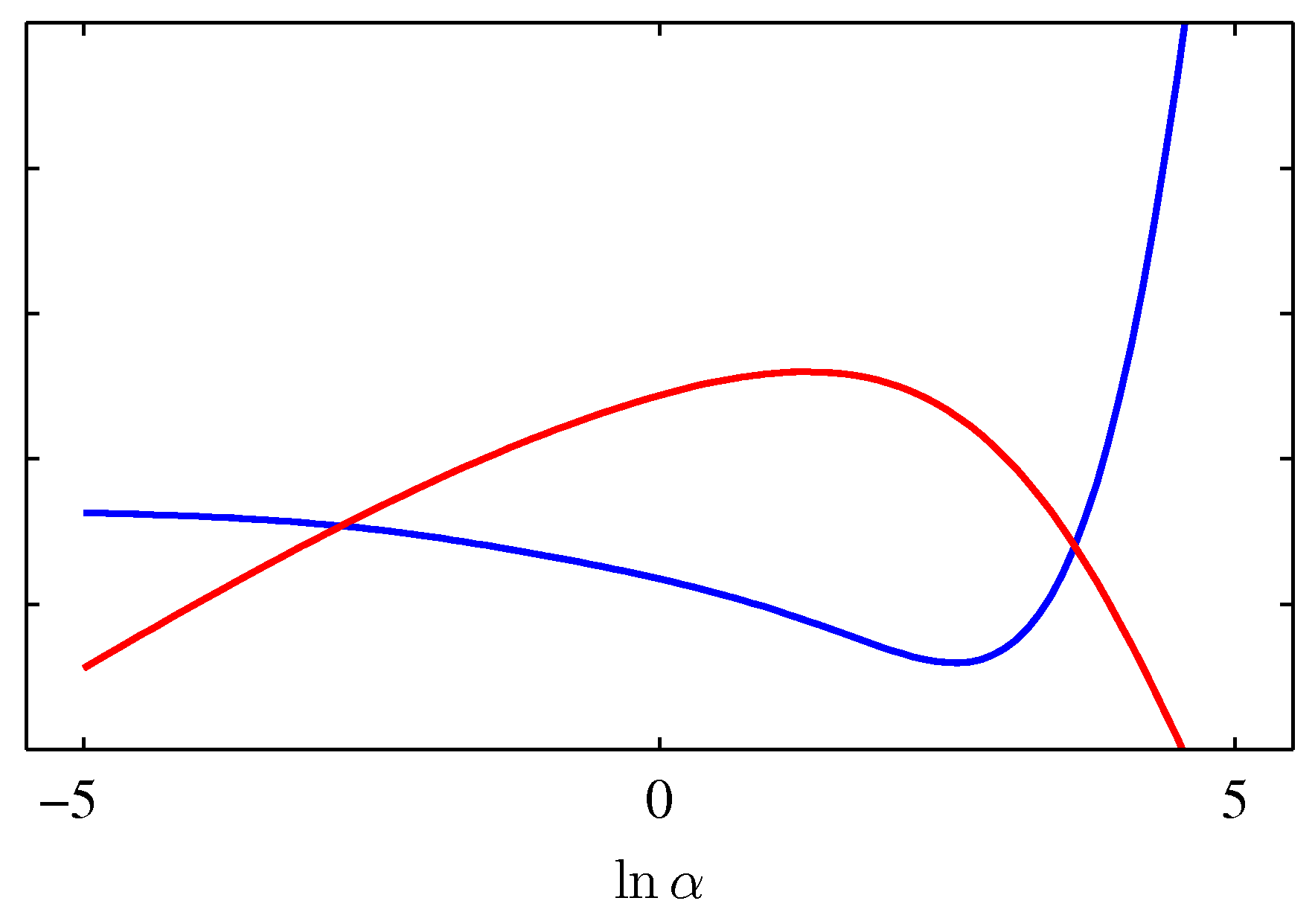

N≫M としたときの α の推定解

データ点がモデルパラメータより十分大きい(N≫M)とき、すべてのパラメータはwell-determined.

γ=M となり、 α=M2Ew(mN)

γ=2αEw(mN) となるので両辺の交点が最適となる。

γ と 2αEw(mN)

lnp(t|α,β) と テスト集合での誤差

3.6 固定された基底関数の限界

線形回帰モデル

- 固定された非線形基底関数 ϕ を線形結合したモデル

- パラメータの線形性を仮定

- 「微分とって0」で最尤解が求まった

- ベイズ推定もしやすかった

- 任意の非線形変換をモデル化できる

- が、パターン認識の問題を解く一般的な枠組みとはなり得ない

線形回帰モデルの問題点

- 訓練データ集合 D の観測前に非線形基底関数 ϕ を固定している

- → 次元の呪い(1.4節)

- データの次元数に対して指数関数的に関数を用意する必要

現実的なデータ集合には、問題を軽減する2つの性質がある

- データの本質的な次元数は実際より低い(次元間の相関)

- 手書き文字で言えば、個々のデータの違いは垂直・水平・回転の3次元がメイン

- 基底関数を局所に絞ることができる

- RBF, SVM, RVM で使われる手法

- NNはシグモイド関数を適応的に配置できる

- 目標変数がデータ多様体の少数の可能な方向にのみ強く依存

- NNは入力空間で基底関数が反応する方向を選ぶことでこの性質を活用